Google kini mengumumkan Ironwood, Unit Pemprosesan Tensor (TPU) generasi ke-7, yang merupakan pemecut AI tersuai berprestasi tinggi dan boleh ditingkatkan, serta yang pertama direka khusus untuk inferens.

Ironwood mewakili perubahan besar dalam pembangunan AI dan infrastruktur yang menyokong kemajuannya. Ia menandakan peralihan daripada model AI yang responsif, yang memberikan maklumat masa nyata untuk diterjemah oleh manusia, kepada model yang menghasilkan pengetahuan mendalam dan tafsiran secara proaktif. Inilah yang kami sebut sebagai “era inferens”, di mana ejen AI akan secara proaktif mengambil dan menghasilkan data untuk secara kolaboratif menyampaikan pengetahuan dan jawapan, bukan sekadar data.

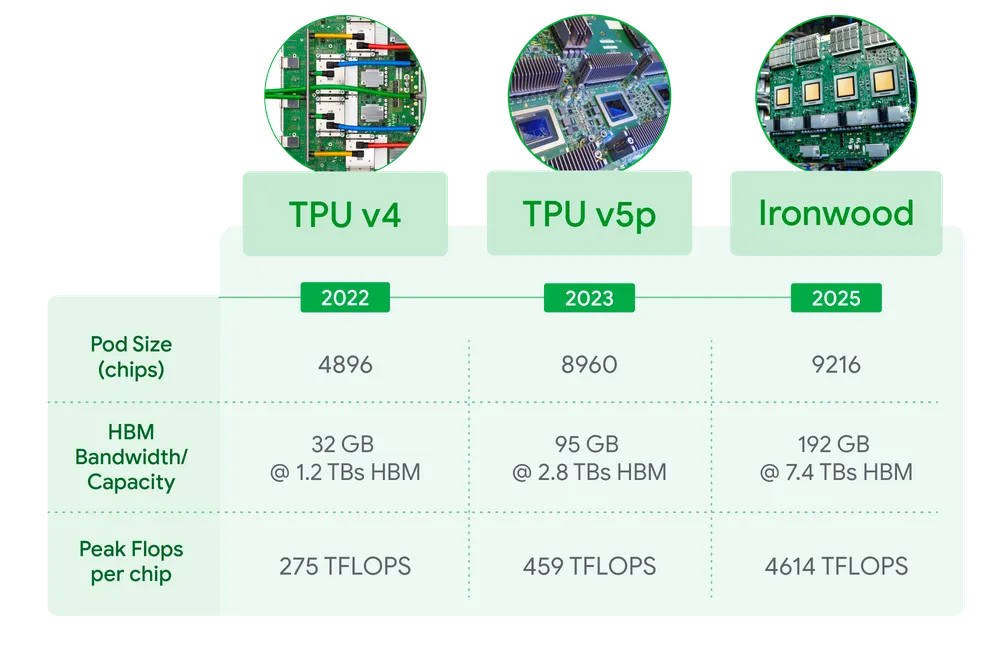

Dijadualkan pelancaran lewat tahun ini untuk pelanggan Google Cloud, Ironwood akan tersedia dalam dua saiz berdasarkan keperluan beban kerja AI – konfigurasi 256 cip dan 9,216 cip.

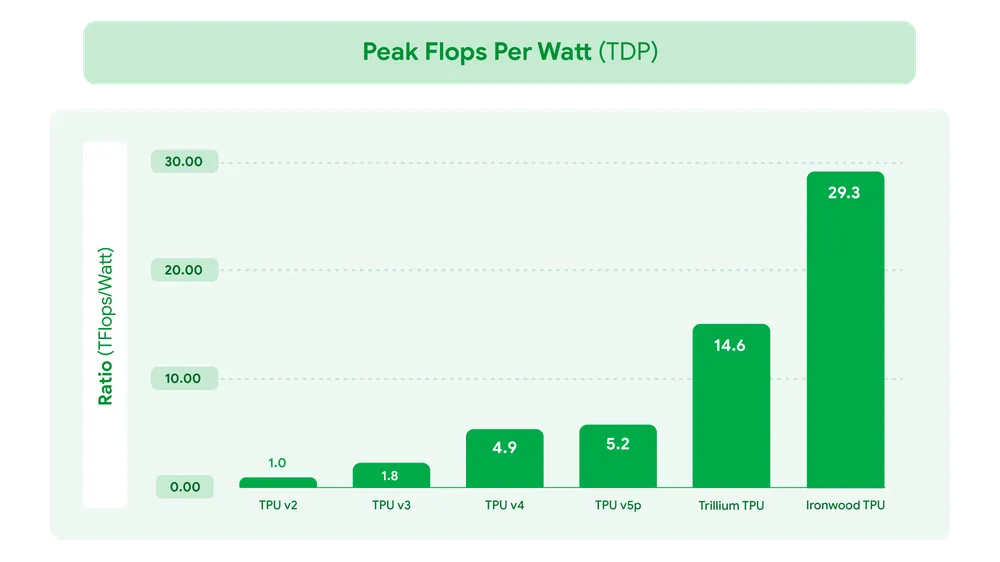

Setiap cip individu mempunyai kapasiti memori 192GB RAM (6x Trillium) dengan lebar jalur High Bandwith Memory (HBM) yang mencecah 7.2 TBps (4.5x Trillium) serta menawarkan kapasiti pengkomputeran puncak sebanyak 4,614 TFLOPs.

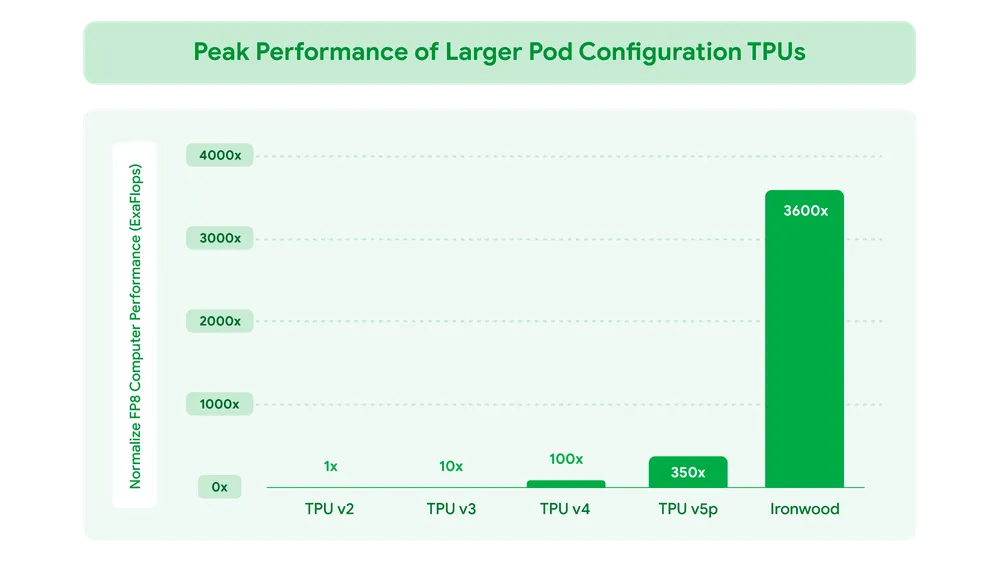

Apabila ditingkatkan kepada 9,216 cip setiap pod untuk jumlah 42.5 Exaflops, Ironwood dikatakan mempunyai keupayaan untuk menyokong lebih daripada 24 kali ganda kuasa pengkomputeran superkomputer terbesar di dunia, El Capitan, yang menawarkan hanya 1.7 Exaflops setiap pod.

Ironwood direka untuk menguruskan dengan cekap keperluan pengkomputeran dan komunikasi yang kompleks bagi “model berfikir,” yang merangkumi Model Bahasa Raya (LLM), Mixture of Experts (MoE) dan tugas pemikiran lanjutan.

Dengan Ironwood, pembangun juga boleh menggunakan rangkaian perisian Pathways milik Google untuk kuasa pengkomputeran gabungan puluhan ribu TPU Ironwood dengan cara yang boleh dipercayai dan mudah.

{suggest}

Sumber: Google