Pusat penyelidikan di bawah Foxconn, Hon Hai Research Institute, hari ini mengumumkan pelancaran Model Bahasa Raya (LLM) pertamanya, bertujuan untuk memanfaatkan teknologi ini dalam sektor pembuatan dan pengurusan rantaian bekalan.

Dikenali dengan nama kod “FoxBrain“, model ini dibangunkan berdasarkan seni bina Meta Llama 3.1 dengan 70 bilion parameter.

FoxBrain dilatih menggunakan 120 unit GPU Nvidia H100, dipertingkat dengan rangkaian NVIDIA Quantum-2 InfiniBand serta disiapkan dalam tempoh kira-kira empat minggu – menjadikannya antara model yang paling cekap dari segi kos dan masa latihan.

Sebagai model LLM pertama di Taiwan dengan keupayaan penaakulan (reasoning), FoxBrain dioptimumkan khusus untuk Bahasa Cina Tradisional dan gaya bahasa pengguna Taiwan.

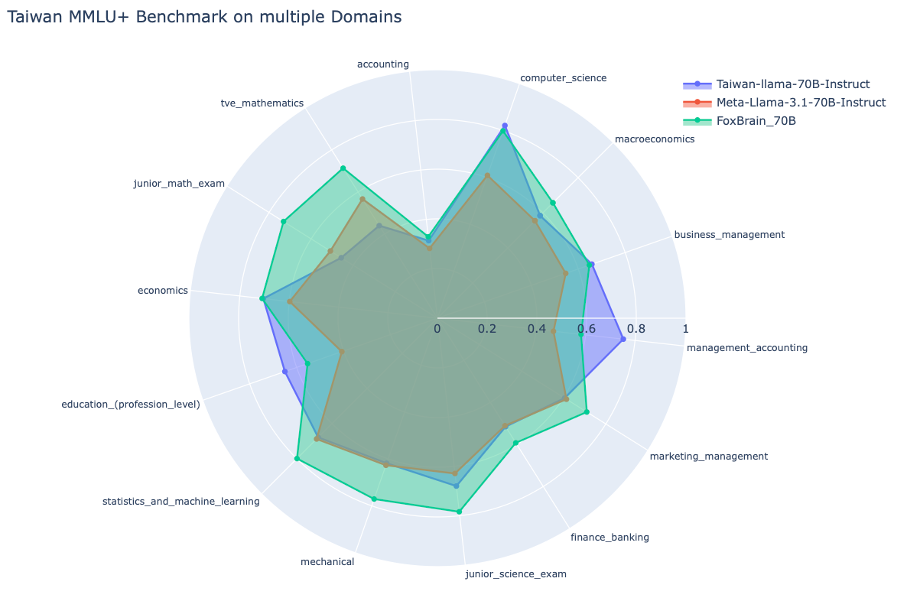

Dalam set ujian TMMLU+, ia mengatasi Llama-3-Taiwan-70B yang berskala sama, dengan prestasi lebih tinggi dalam matematik dan penaakulan logik.

Walaupun masih terdapat sedikit jurang prestasi berbanding model DeepSeek dari China, Foxconn menyatakan bahawa prestasi keseluruhan FoxBrain hampir mencapai standard bertaraf dunia.

Pada asalnya, ia dibangunkan untuk aplikasi dalam sistem dalaman Foxconn, merangkumi fungsi seperti analisis data, sokongan keputusan, kolaborasi dokumen, matematik, penaakulan, penyelesaian masalah serta penjanaan kod.

Dalam usaha memperluas aplikasinya, syarikat itu akan terus bekerjasama dengan rakan teknologi, berkongsi maklumat sumber terbuka, serta mempromosikan penggunaan kecerdasan buatan (AI) dalam pembuatan dan pengurusan rantaian bekalan.

Sepanjang proses latihan model, NVIDIA turut memberikan sokongan melalui superkomputer terbesar di Taiwan, Taipei-1, serta menyediakan konsultasi teknikal.

Butiran lanjut mengenai FoxBrain akan diumumkan semasa NVIDIA GTC 2025 Session Talk pada 20 Mac.

{suggest}

Sumber: Foxconn