Apple sering dikait dengan menjaga privasi penggunanya. Namun, selepas ini mereka akan melakukan sedikit “pencerobohan” terhadap privasi pengguna dengan mengumumkan sebuah fungsi baharu .

Fungsi tersebut adalah sebagai salah satu langkah melindungi keselamatan kanak-kanak dimana Apple mahu menghentikan “Child Sexual Abuse Material” (CSAM). Dalam CSAM ini, tiga langkah utama yang diambil oleh Apple.

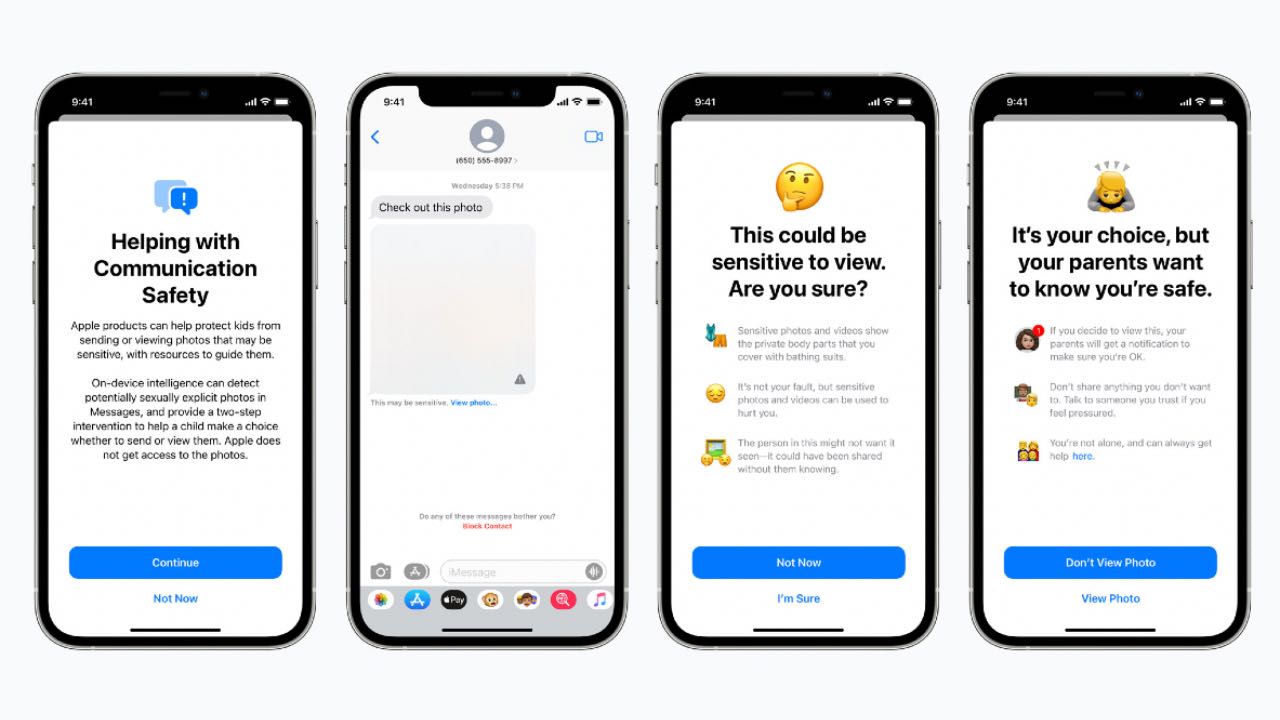

Pertama sekali, Apple akan menambah satu fungsi di dalam iMessage dimana sekiranya gambar atau video yang sensitif seperti mendedahkan bahagian sulit dan sebagainya, secara automatik ia akan dikaburkan dan mesej amaran dipaparkan.

Sekiranya ibu bapa yang aktifkan “Family Sharing” dengan anak-anak, mereka boleh mengetahui apabila anak mereka membuka gambar atau video sensitif tersebut.

Kedua, sebuah teknologi baharu menggunakan kriptografi akan dilaksanakan yang mana gambar-gambar CSAM atau bahan yang sensitif melibatkan kanak-kanak diimbas apabila ia disimpan di iCloud Photos.

Akan tetapi, Apple bukan melihat gambar-gambar yang dimuat naik di iCloud Photos. Sebaliknya, satu teknologi akan mengimbas data-data hash dan cuba memadankan sama ada gambar tersebut ada kaitan dengan unsur pornografi dan sebagainya.

Akhir sekali, Siri akan membantu jika pengguna mahu melaporkan perkara yang berkaitan CSAM. Selain itu, jika pengguna cuba membuat carian terhadap topik-topik melibatkan isu sensitif kanak-kanak, Siri akan masuk campur dan menghalang perbuatan anda.

Kesemua ciri baharu ini akan tersedia buat semua pengguna iOS 15, iPadOS 15 dan juga macOS Monterey nanti.

Sumber: Apple

Baca juga artikel berkaitan: